Stable Diffusion

Qué es y por qué está revolucionando la generación de contenido por inteligencia artificial

En los últimos años, la inteligencia artificial (IA) ha dado pasos de gigante, especialmente en el campo de la generación de imágenes. Uno de los avances más destacados en este ámbito es Stable Diffusion, un modelo de difusión de código abierto que permite generar imágenes realistas y creativas a partir de descripciones de texto. Este artículo explora qué es Stable Diffusion, cómo funciona, quién lo ha desarrollado y por qué es una de las herramientas más influyentes en el panorama actual de la IA generativa.

¿Qué es Stable Diffusion?

Stable Diffusion es un modelo de inteligencia artificial basado en redes neuronales profundas que genera imágenes a partir de texto. Es decir, el usuario introduce una descripción (“prompt”) como “una ciudad futurista al atardecer”, y el sistema produce una imagen que refleja esa idea.

Este modelo pertenece a la familia de los modelos de difusión, que aprenden a generar datos (como imágenes) revirtiendo un proceso de ruido. Durante el entrenamiento, el modelo aprende cómo degradar imágenes con ruido y, luego, cómo invertir ese proceso para generar imágenes nuevas desde el ruido puro, guiado por texto.

¿Cómo funciona Stable Diffusion?

Stable Diffusion emplea una técnica llamada difusión latente. A diferencia de los modelos que trabajan directamente con imágenes en alta resolución (como píxeles de 512×512 o 1024×1024), este sistema primero comprime la imagen a un espacio latente —una representación numérica más compacta—, realiza el proceso de generación en ese espacio, y luego la decodifica de vuelta a una imagen visible.

El proceso se puede resumir así:

- Codificación latente: Se toma una imagen y se transforma a una representación más abstracta mediante un encoder (utilizando un modelo VAE – Autoencoder Variacional).

- Difusión inversa: En ese espacio latente, se añade ruido progresivamente durante el entrenamiento, y luego se entrena al modelo para revertir el proceso, eliminando ese ruido paso a paso.

- Condicionamiento por texto: El modelo usa un componente de lenguaje (como CLIP o BERT) para guiar la generación visual a partir de un texto dado.

- Decodificación: Finalmente, la imagen se reconstruye a partir de su forma latente.

Este proceso permite generar imágenes de alta calidad con un menor consumo de recursos computacionales.

Aplicaciones y usos

Desde su lanzamiento, Stable Diffusion ha sido utilizado en una amplia gama de aplicaciones:

- Arte generativo: Ilustradores y diseñadores pueden crear bocetos rápidos o conceptos artísticos.

- Publicidad y diseño gráfico: Creación de imágenes personalizadas para campañas.

- Videojuegos y animación: Generación de entornos, personajes o texturas.

- Educación e investigación: Uso en visualización científica o prototipos creativos.

- Moda y arquitectura: Simulación de prendas, espacios y productos.

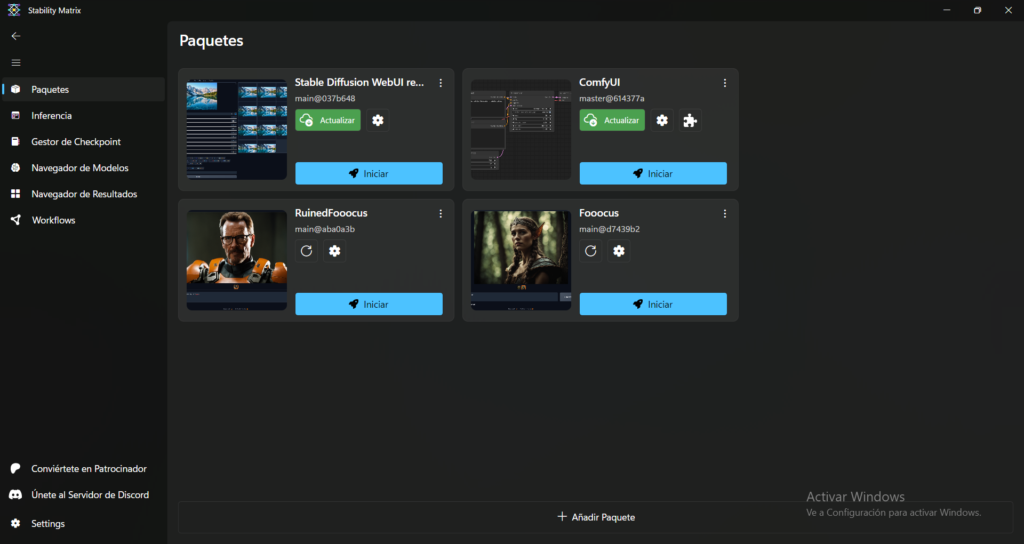

Además, han surgido múltiples interfaces de usuario y plataformas que utilizan este motor, como DreamStudio, InvokeAI, o Automatic1111, esta última especialmente popular entre usuarios avanzados por su amplia capacidad de personalización.

Ventajas y desafíos

Ventajas

- Código abierto: Permite su libre modificación, adaptación y despliegue.

- Eficiencia: Puede correr en equipos con GPU de gama media (por ejemplo, tarjetas gráficas con 6-8 GB de VRAM).

- Alta calidad: Capaz de generar imágenes fotorrealistas y artísticas en segundos.

- Flexible: Admite modificaciones mediante modelos personalizados (LoRA, checkpoints, embeddings) y combinación de estilos.

Desafíos

- Derechos de autor: El modelo fue entrenado con imágenes de Internet, algunas protegidas por copyright, lo que ha generado controversias legales.

- Desinformación: Puede usarse para generar contenido falso o deepfakes.

- Regulación: Aún hay incertidumbre jurídica sobre el uso comercial de imágenes generadas por IA.

- Ética: El fácil acceso a esta tecnología plantea dilemas sobre el reemplazo de trabajos creativos y la generación de contenido sensible.

Evolución y futuro

Desde su versión inicial, Stable Diffusion ha lanzado múltiples iteraciones:

- Stable Diffusion 1.4 y 1.5: Versiones ampliamente adoptadas en comunidades como Hugging Face y Reddit.

- Stable Diffusion 2.0 y 2.1: Incorporaron mayor resolución y mejor manejo de detalles.

- Stable Diffusion XL (SDXL): Presentada en 2023, esta versión ofrece mejoras sustanciales en coherencia, realismo y generación de texto en imágenes.

El futuro apunta a una convergencia entre modelos de texto, imagen y vídeo. Stability AI ya está desarrollando modelos capaces de generar clips animados, además de mejorar las capacidades 3D a partir de una sola imagen.

Conclusión

Stable Diffusion ha democratizado el acceso a la generación de imágenes por IA, empoderando tanto a artistas como a desarrolladores con una herramienta potente, flexible y de código abierto. Si bien plantea desafíos éticos y legales, su potencial creativo y transformador es innegable. Estamos solo al principio de una nueva era visual impulsada por la inteligencia artificial, y Stable Diffusion es uno de sus protagonistas principales.